Das Release der KI-Anwendung ChatGPT dominiert aktuell die öffentliche Debatte über Fähigkeiten und Auswirkungen von Künstlicher Intelligenz. Mit seinen beeindruckenden Fähigkeiten im Bereich der Verarbeitung menschlicher Sprache und Vielseitigkeit in den Anwendungsbereichen ist ChatGPT derzeit unübertroffen. Der Hype um die Technologie ist also durchaus berechtigt, übersieht aber in vielen Bereichen, dass sie mit der aktuellen Architektur für viele Anwendungsbereiche und Bedürfnisse von Unternehmen keine Lösung darstellen wird. Die Gründe dafür liegen weniger in den Grenzen der Technologie als in der Governance und Regulierung des Einsatzes (Trusted AI).

Ein unverzichtbarer Leitfaden für alle, die für den verantwortungsvollen Einsatz von KI in Unternehmen verantwortlich sind.

Die Grenzen der Technologie

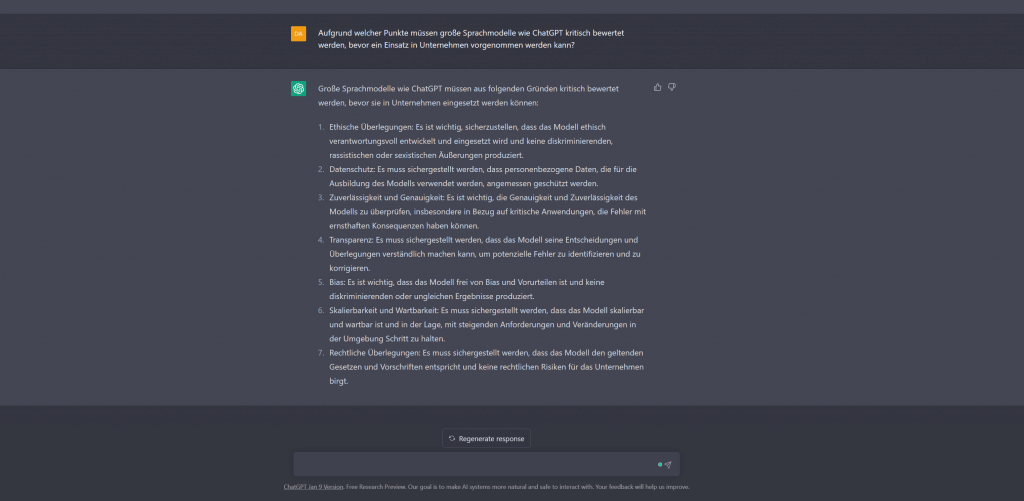

Der von OpenAI mit ChatGPT angebotene Cloud-Service muss aufgrund der folgenden Punkte kritisch bewertet werden, bevor ein Einsatz in Unternehmen vorgenommen wird:

Trust

Die großartigen Fähigkeiten der Maschine täuschen darüber hinweg, dass den generierten Ergebnissen nur bedingt vertraut werden kann. Die mangelnde Überprüfbarkeit der Ergebnisse aufgrund eines möglichen Bias, gepaart mit mangelnder Transparenz, machen einen Einsatz im Unternehmen schwierig. Es fehlt an Trust (also Vertrauen) in die KI. Doch der Reihe nach:

Die Vertrauenswürdigkeit der generierten Ergebnisse ist aufgrund der fehlenden Überprüfbarkeit eingeschränkt. Im Gegensatz zu einer Suchmaschine wie Google, die Antworten aus konkreten Informationsquellen liefert, generiert ChatGPT Antworten, synthetisiert auf der Basis von erlerntem Weltwissen. ChatGPT verzichtet auf Quellenangaben oder ähnliches, die ein Ergebnis direkt überprüfbar machen würden. Es ist daher nicht nachvollziehbar, auf welchen Daten die KI trainiert wurde und ob diese repräsentativ, aktuell und valide sind.

Wie alle KI-Modelle reproduziert auch ChatGPT einen Bias in den Trainingsdaten, der zu ungenauen oder unfairen Ergebnissen führen kann. Das bedeutet, dass ChatGPT unbeabsichtigt Voreingenommenheit oder Ungerechtigkeit in seine Antworten einbauen kann. Dies kann zum Beispiel durch unterrepräsentierte Gruppen in den Trainingsdaten verursacht werden, was dazu führt, dass bestimmte Perspektiven oder Erfahrungen nicht berücksichtigt werden. Wenn Unternehmen, die KI-Systeme einsetzen, die Datenbasis, auf der die eingesetzten Modelle trainiert wurden, nicht kontrollieren und einsehen können, können sie sich des vorliegenden Bias nicht bewusst sein und die Ergebnisse entsprechend kritisch bewerten.

Fehlende Überprüfbarkeit hängt eng zusammen mit einem anderem wichtigen Entscheidungskriterium für die Nutzung von KI:

Transparenz

Transparenz ist ein entscheidender Faktor für den Einsatz von KI-Systemen wie ChatGPT. Die Entscheidungsprozesse solcher KI-Modelle und die genauen Modelloperationen sind jedoch oft nur schwer nachvollziehbar. In diesem Zusammenhang werden solche großen Cloud-Systeme oft mit einer Blackbox verglichen. Der Benutzer gibt einen Befehl und am Ende kommt eine Entscheidung, ein Ergebnis heraus. Wie es zu diesem Ergebnis gekommen ist, bleibt jedoch völlig unklar. Dies ist besonders problematisch, wenn es darum geht, die Ergebnisse von KI-Modellen zu bewerten oder zu interpretieren. Mangelnde Nachvollziehbarkeit und Transparenz können dazu führen, dass Modelle nicht vertrauenswürdig sind und die Ergebnisse nicht sicher verwendet werden können. Daher ist es wichtig, die kreative und synergetische Leistung bis zu den ursprünglichen Trainingsdaten zurückverfolgen zu können, um Modellentscheidungen nachvollziehen und bewerten zu können.

Eine Studie von PwC bestätigt diese Kritik: Nahezu alle befragten Unternehmen legen demnach beim Einsatz von KI-Modellen sehr großen Wert auf Sicherheit, Transparenz (auch bei der Auswahl der Trainingsdaten) und Vertraulichkeit. Diese Voraussetzungen für den Einsatz von Künstlicher Intelligenz in Unternehmen können große Sprachmodelle wie ChatGPT kaum erfüllen.

Reproduzierbarkeit und Zuverlässigkeit

Eine große Herausforderung beim Einsatz von ChatGPT ist die mangelnde Reproduzierbarkeit und Zuverlässigkeit der Ergebnisse. Dies liegt daran, dass große Sprachmodelle wie ChatGPT auf einer enormen Datenmenge trainiert wurden und ständig dazu lernen, was sie zu einer „kreativen“ KI macht. Dadurch ist es jedoch oft schwierig, das Verhalten und die Antworten der Maschine vorherzusagen und zu reproduzieren. Dies kann zu Problemen führen, insbesondere bei Anwendungen, die präzise und zuverlässige Ergebnisse erfordern.

Man stelle sich eine Versicherungsgesellschaft vor, die ein großes Sprachmodell wie ChatGPT verwendet, um die Risikobewertung von Versicherungsanträgen automatisch durchzuführen. Wenn das Modell jedoch ständig lernt und die Operationen nicht nachvollzogen werden können, kann es passieren, dass es für jeden Antrag eine andere Bewertung vornimmt oder diese nicht nachvollziehbar sind.

Dies stellt ein großes Problem dar, da Versicherungen auf eine zuverlässige und reproduzierbare Bewertung angewiesen sind, um faire und konsistente Entscheidungen treffen zu können. Unsicherheit und Unvorhersehbarkeit können schnell zu Fehlentscheidungen und Ungerechtigkeit führen.

Solange diese Sprachmodelle wie ChatGPT nur als Blackbox funktionieren, und sich nicht in die Karten schauen lassen, können sie nicht in Unternehmensprozesse eingebunden werden.

Vertraulichkeit und Datenschutz

Der Einsatz von ChatGPT birgt für Unternehmen ein weiteres hohes Risiko, da sowohl die Transparenz der Verarbeitung von Unternehmensdaten als auch die Einhaltung der Bestimmungen der DSGVO problematisch sind. Es ist nicht transparent, wo und wie die KI neue Informationen speichert und ob diese dann als „geistiges Eigentum“ betrachtet. Darüber hinaus steht der Einsatz von ChatGPT in vielen betrieblichen Anwendungsszenarien im Widerspruch zu den Grundsätzen der Datenschutz-Grundverordnung, was zu Sanktionen führen und Unternehmen in eine schwierige Lage bringen kann.

Im Zusammenhang mit der Diskussion um Einschränkungen und Grenzen von KI-Systemen wie ChatGPT spielt die Governance und Regulierung des Einsatzes von KI eine wichtige Rolle. In Deutschland gibt es bereits verschiedene Bestrebungen, KI-Systeme zertifizieren zu lassen. Ein Beispiel ist die Initiative „Trustworthy AI“ der Europäischen Kommission, die sich auf die Schaffung von Rahmenbedingungen für ethisch vertretbare und verantwortungsvolle Anwendungen von KI-Systemen konzentriert. Weitere Initiativen gibt es von PwC und Deloitte sowie von Verbänden wie dem VDE, die sich auf die Schaffung von (ethischen) Leitlinien und Standards für den Einsatz von KI in Unternehmen konzentrieren.

Gewährleisten Ethical AI-Zertifizierungen einen verantwortungsvollen Umgang?

Es ist jedoch fraglich, ob solche Zertifizierungen tatsächlich in der Lage sind, einen ethischen und verantwortungsvollen Einsatz von KI-Systemen zu gewährleisten. Es gibt noch viele Unsicherheiten und Herausforderungen zu bewältigen, wenn es darum geht, KI-Systeme in einer Weise einzusetzen, die den Interessen und dem Wohl aller Beteiligten entspricht.

Insgesamt ist es wichtig, den Einsatz von KI-Systemen so zu regulieren, dass sowohl die Interessen der Entwickler und Nutzer als auch die Interessen der Gesellschaft insgesamt berücksichtigt werden. Während Zertifizierungen wie „Trustworthy AI„, „Ethical AI“ und „AI Trust Label„, oder Selbstevaluationskataloge wie ALTAI oder AIC4 ein Schritt in die richtige Richtung sein können, ist es auch wichtig, kritisch zu hinterfragen, ob diese Zertifizierungen tatsächlich in der Lage sind, die Probleme und Herausforderungen zu lösen, die mit dem Einsatz von KI-Systemen verbunden sind. Es ist wichtig, dass Entwickler, Nutzer und Regulierungsbehörden gemeinsam an Lösungen arbeiten, um sicherzustellen, dass KI-Systeme ethisch und verantwortungsvoll eingesetzt werden und einen positiven Beitrag zur Gesellschaft leisten.

In welchen Anwendungsfällen wird eine andere Herangehensweise von Künstlicher Intelligenz benötigt?

Integration in den Unternehmenskontext

Compliance, Datenschutz und in vielen Bereichen auch Regulierung (insbesondere im Gesundheits- und Finanzsektor) erfordern den Einsatz von KI unter der Kontrolle des anwendenden Unternehmens. Aus technologischer Sicht erfordert dies die Möglichkeit, KI on-premise oder in einer hybriden Cloud-Architektur einzusetzen. Letztere ermöglicht beispielsweise den Einsatz von „Trusted AI“, um personenbezogene Daten zu anonymisieren oder vertrauliche Informationen herauszufiltern, um sie anschließend in einer Public-Cloud-Infrastruktur wie Microsoft Azure weiterzuverwenden.

Die Integration in den Unternehmenskontext ist nicht nur technisch zu sehen. Ebenso entscheidend ist die Nutzung unternehmensinterner Daten für das Training und die Steuerung der KI. KI wird nicht nur an der Schnittstelle zur Interaktion mit Menschen eingesetzt, sondern auch zur automatisierten Analyse und Aufbereitung von Daten. Auch hier ist es notwendig, die KI kontinuierlich mit vielfältigen Daten aus dem Unternehmen zu füttern, um sie für den spezifischen Unternehmenskontext zu optimieren.

Herausforderungen bei der Implementierung von KI ist meist die Compliance und der Datenschutz

Der Einsatz von KI in Unternehmen ist häufig mit Compliance-Anforderungen, Datenschutzbestimmungen und regulatorischen Anforderungen (insbesondere im Gesundheits- und Finanzsektor) verbunden. Um diesen Anforderungen gerecht zu werden, ist es erforderlich, dass KI-Systeme unter der Kontrolle des jeweiligen Unternehmens betrieben werden. Aus technologischer Sicht erfordert dies die Möglichkeit, KI entweder vor Ort oder in einer hybriden Cloud-Architektur zu betreiben.

Neben der technischen Integration von KI in den Unternehmenskontext ist es von großer Bedeutung, dass unternehmensinterne Daten für das Training und die Steuerung von KI genutzt werden. KI-Systeme werden nicht nur in der Interaktion mit Menschen eingesetzt, sondern auch zur automatischen Analyse und Aufbereitung von Daten. Um die KI an den spezifischen Unternehmenskontext anzupassen, ist es daher unerlässlich, sie regelmäßig mit einer Vielzahl von Unternehmensdaten zu versorgen.

Der Mangel an Trust, Zuverlässigkeit, Nachvollziehbarkeit und Reproduzierbarkeit ist ein generelles Problem bei cloudbasierten KI-Diensten, einschließlich ChatGPT. Unter diesem Mangel leiden jedoch auch viele KI-Modelle, die in Unternehmen entwickelt werden. Der Grund dafür ist das Fehlen von Prozessen, Verfahren und Anwendungen, die es ermöglichen, Transparenz und Nachvollziehbarkeit auf Basis der eigenen Daten zu schaffen und nicht nur die Möglichkeiten der KI, sondern auch ihre limitierenden Faktoren sichtbar und systematisch beherrschbar zu machen.

Bewusst komplementäre Architektur von KI-Software

Aus diesem Grund haben wir unser Produkt CONTEXTSUITE bewusst komplementär zu herkömmlichen Ansätzen konzipiert. Sie unterstützt mit einer durchgängigen Verarbeitungspipeline und visuellen Analysewerkzeugen das systematische End-to-End-Engineering von KI-Modellen von der Datenaufbereitung über Werkzeuge zur Bewertung der Zuverlässigkeit von KI-Modellen bis hin zum agilen produktiven Einsatz. Nur so kann zuverlässiges Data-Driven Business umgesetzt und produktiv genutzt werden!

Fazit

ChatGPT und nachfolgende Lösungen werden viele Anwendungsbereiche und Branchen disruptiv verändern. Dies betrifft alle Bereiche, in denen kreative Prozesse auf Basis nicht vertraulicher oder anderweitig sensibler Daten automatisiert werden sollen. Dies gilt insbesondere für den Einsatz im Bereich der Kommunikation, des Marketings sowie der Entwicklung von Konzepten und Quellcode.

In allen Anwendungsbereichen, in denen Unternehmen entweder mit sensiblen Daten agieren oder beim Einsatz von KI auf Reproduzierbarkeit, Verlässlichkeit oder die Möglichkeit der Standardisierung und Kontextualisierung in Bezug auf die eigene Datenwelt angewiesen sind, ist der Einsatz von spezialisierter, zuverlässig kontrollierbarer und transparenter KI notwendig. Dies betrifft sowohl die Automatisierung von Prozessen als auch die KI-gestützte Aufbereitung von Datenprodukten.